守住产品底线防范人工智能

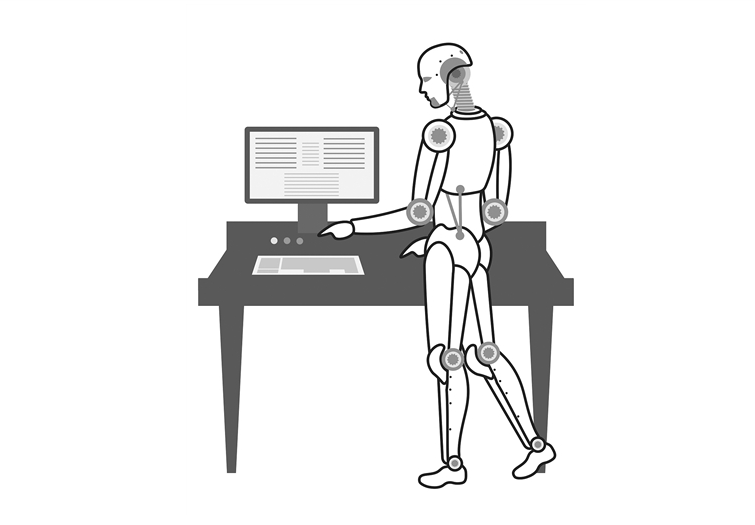

未来10-20年,人工智能技术将渗透到与人类密切相关的领域,如医疗、司法、生产、金融技术等风险敏感领域。如果人工智能技术出了差错,它将带来更大的系统性风险。"2020年12月29日,清华大学计算机系主任、中国科学技术协会全国委员会委员崔鹏在未来科学奖周举行的"青年对话"上说。

活动期间,腾讯科技协会秘书长张倩表示,面对人工智能技术带来的风险,我们首先要注意的是保持AI产品的底线,即避免技术危害。

在这方面,美团首席科学家夏华夏认为,需要在法律法规方面做很多工作,包括制定人工智能行业的标准和规范,以及从国家层面改进和颁布相关法律法规,以控制人工智能技术的发展。

在人工智能标准化实践中,中国人民大学法学院副教授、未来法治研究所社会责任与治理中心主任郭瑞提出了两项原则--人类根本利益原则和责任原则。

郭瑞承认,法律本身也有局限性,为了避免人工智能技术的潜在风险,管理者需要对人工智能技术有一个透彻的了解,以便对其进行有效的监管。"法律是建设包容性社会的重要工具,法律界必须与企业、技术和其他专家合作,才能实现依法管理人工智能技术的目标。

兴业资本管理公司合伙人方元认为,核心数据平台处于AI风险管理的重要地位。在互联网和大数据时代,大平台既是数据的收集器,也是数据的守护者。明确数据使用权的概念,对人工智能在全社会的发展具有重要意义。

人工智能技术的风险管理需要科技工作者、企业经理、政策制定者、相关法律专家和投资者的努力。"中国科学院计算研究所研究员单世光说。

除了保持底线外,与会者还提到需要澄清边界,引导技术向好的方向发展。

崔鹏指出,犯错误对人工智能来说并不是唯一的风险,人们也会犯错误。目前,如果人工智能技术犯了一个错误,它是不可预测的,或者在犯了错误之后,人们会发现错误的机制无法从技术层面加以解释。这涉及到人工智能在决策和行为上的边界.

为了澄清界限,人工智能需要了解它会做什么,它不会做什么,人们需要了解人工智能能做什么,它不能做什么等等。崔鹏认为,如果边界不被澄清,人工智能将犯更低级别的错误,并带来更大的风险。

郭瑞认为,人工智能目前遇到的伦理问题其实是因为它远未达到人类的智力水平,但它被赋予了为人类做出决策的责任。"有人以人工智能技术为借口,以科学的名义做出不道德的决定,这是错误的。"这取决于人们在需要作出决定的地方作出决定。

在2020年新冠肺炎流行期间,英国使用了一套算法来获取学生分数,导致近40%的学生低于老师的估计分数,导致许多学生错过了著名学校的学习。一些人工智能模型或数据模型没有考虑到社会公平和累积优势,导致计算严谨、结果准确,但不足以支持人工智能做出科学决策,"山井光说。

有专家说,这不是人工智能技术的错。夏华夏说,真正的社会责任是利用人工智能技术人员、企业等。人工智能技术向好的发展要求整个社会文明发展到一定阶段,形成良好的氛围。张倩指出,技术并不可怕,现有的技术问题可以通过技术的进一步发展来解决。